크롤링과 스크래핑

크롤링 : 알고리즘에 의해 인터넷을 탐색하는 프로그램

크롤링: 크롤러가 웹페이지들을 돌아다니는 행위

스크래퍼: 웹페이지의 데이터를 수집하는 프로그램

스크래핑: 웹페이지의 데이터를 수집하는 행위

=> 통상적으로 크롤링과 스크래핑을 합쳐서 크롤링이라고 표현함

클라이언트와 서버

클라이언트

-웹 브라우저 및 웹

예) 스마트폰 앱, 크롬, 인터넷 익스플로러

서버

-클라이언트의 처리를 도와주는 것

-클라이언트가 필요로 하는 데이터를 제공

-인터넷 주소창에 주소를 입력하고 사이트에 접속하는 행위

=> 서버에 접속

응답코드

서버가 클라이언트 요청을 처리하고 난 후 상태에 따라 반환하는 코드

| 100번대 | 200번대 | 300번대 | 400번대 | 400번대 |

| 조건부 응답 | 성공 | 리다이렉션 완료 | 요청 오류 | 서버 오류 |

| -클라이언트가 데이터를 일부만 포함한 채로 보내서 서버가 데이터를 더 보내달라고 하는 응답코드 | -서버가 클라이언트로부터 요청을 성공적으로 처리한 후 반환하는 응답코드 | -클라이언트가 요청을 완료하기 위해 작업이 남아있는 코드 -보통 새로고침을 한 경우 반환하는 응답코드 |

-클라이언트의 요청이 잘못됐을 때 반환하는 응답코드 -문제 발생의 원인이 클라이언트에 있다는 뜻 |

-서버의 설정, 코드 등의 문제로 오류가 났을 때 반환되는 코드 |

400번대, 주로 주소가 사라졌을 때 404 not found가 뜬다.

새로고침이란?

룸 클리닝이 아니라, 똑같이 생긴 또 다른 방을 만들어 이동시키는 것.

300번대 코드를 반환하게 된다.

Url 구조

통신 프로토콜 = 통신 규약 : 통신하는 방법

- 인터넷에서 주로 사용하는 것은 http, https

-그 외에 FTP, SFTP, SSH 등이 있다.

주소 또는 IP

- 데이터를 요청하는 타겟

포트번호: 공항 게이트 같은 것

약속 되어 있지 않은 포트 번호를 입력하면 접속이 되지 않는다.

리소스 경로

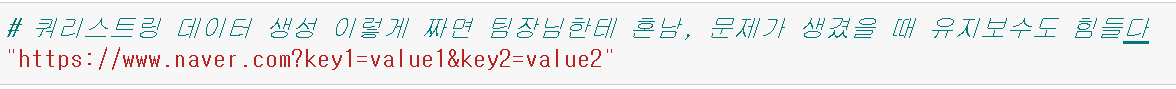

쿼리스트링 : ? 이하

서버에 요청

제대로 된 데이터인지 묻거나 할 때 씀

+설명 추가

쿼리스트링(Query String)은 웹 브라우저나 웹 서버가 웹 서버에게 정보를 전달하기 위해 URL에 추가하는 문자열입니다. 쿼리스트링은 일반적으로 ? 기호로 URL의 경로와 구분되며, & 기호로 여러 개의 쿼리스트링을 연결합니다.

쿼리스트링은 키-값 쌍으로 구성되어 있으며, 각각의 키-값 쌍은 = 기호로 연결됩니다. 예를 들어, https://example.com/search?q=apple&page=2와 같은 URL에서 ? 이후에 오는 q=apple&page=2 부분이 쿼리스트링입니다. 이 경우, q와 page라는 두 개의 키가 있으며, 각각의 값은 apple과 2입니다.

웹 크롤링 방식

1. 정적 크롤링

어느 상황에서나 같은 주소에서 변하지 않는 데이터를 기대할 수 있는 경우

수집 대상에 한계가 있으나 속도가 빠르다.

사용 모듈: BeautifulSoup

2. 동적 크롤링

-입력, 클릭 등 실제 브라우저에서 행하는 행동들을 해야만 데이터를 수집할 수 있는 경우

-수집 대상에 한계가 적으나 속도가 느리다.

-사용 모듈: Selenium

속도가 꽤 많이 차이가 난다.

ex) 24시간에 1000개(동적)->10분에 1000개(정적) 성능 UP!

두 가지 방법을 혼용해서 쓰기도 함

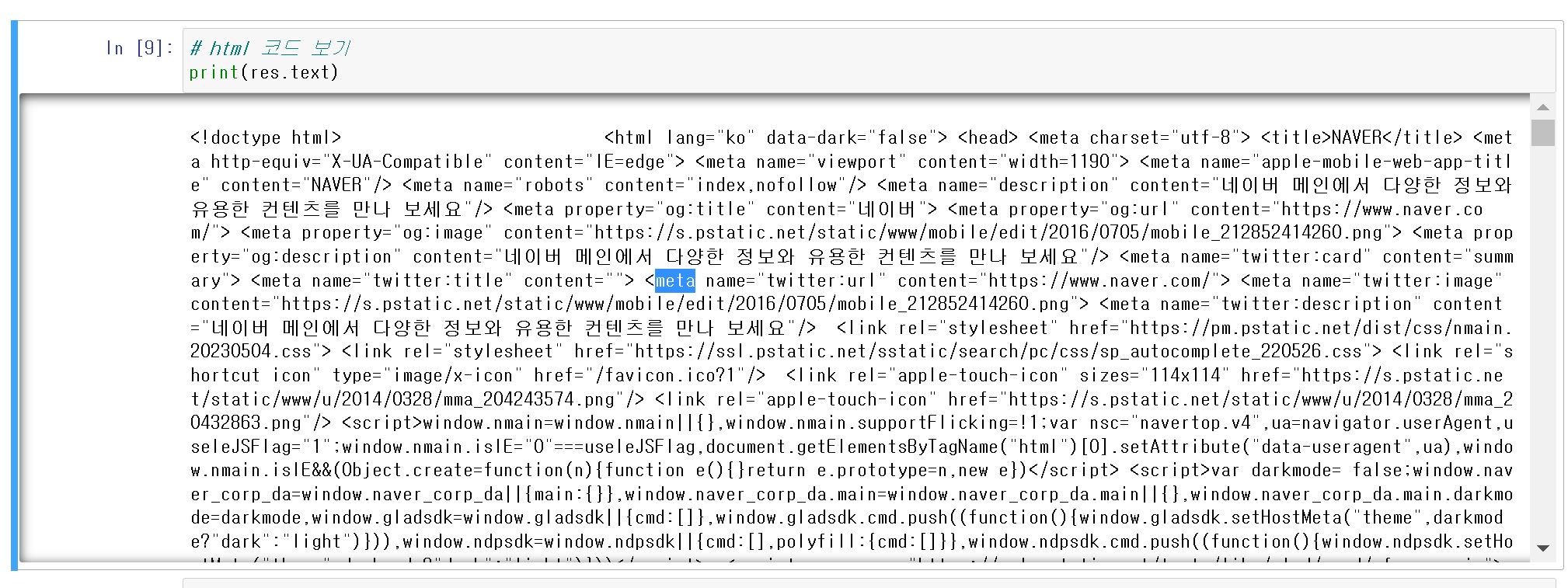

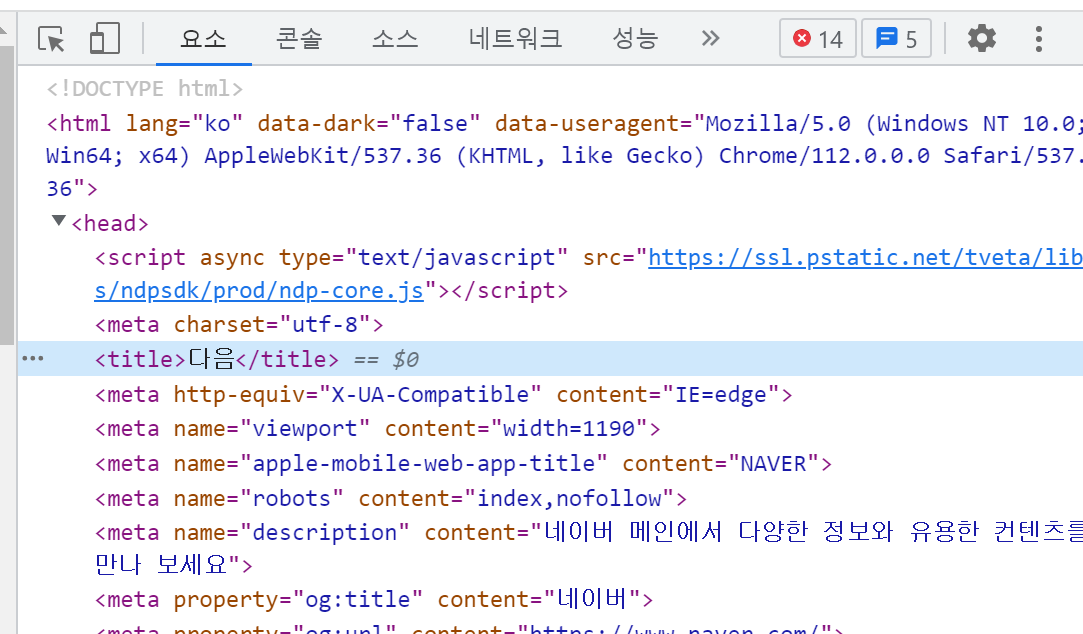

DOM(Document Object Model) tree

DOM: 웹 문서를 브라우저가 이해할 수 있는 구조로 구성하여 메모리에 적재하는 것

DOM tree: HTML 문서를 로드한 후 파싱하여 생성하는 모델

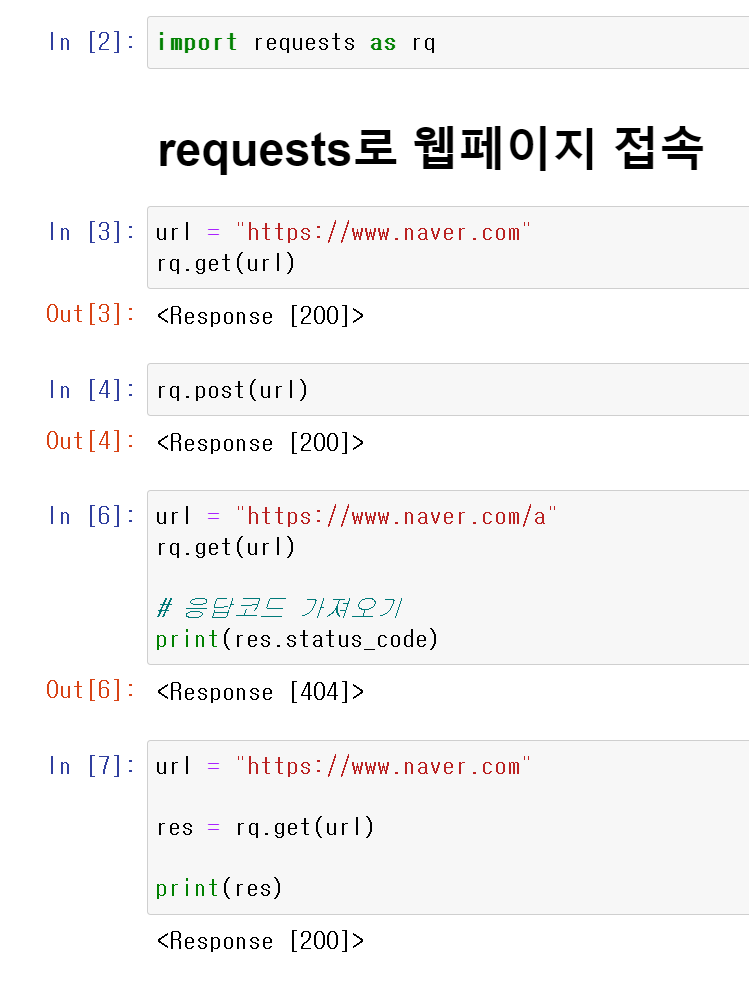

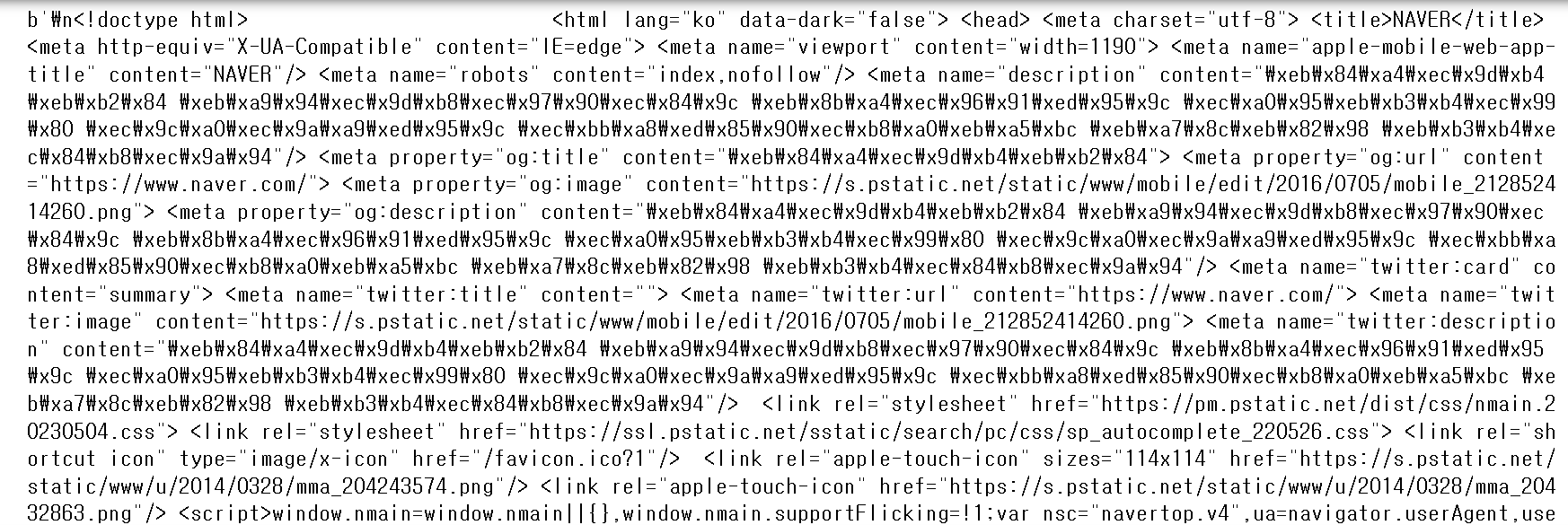

실습

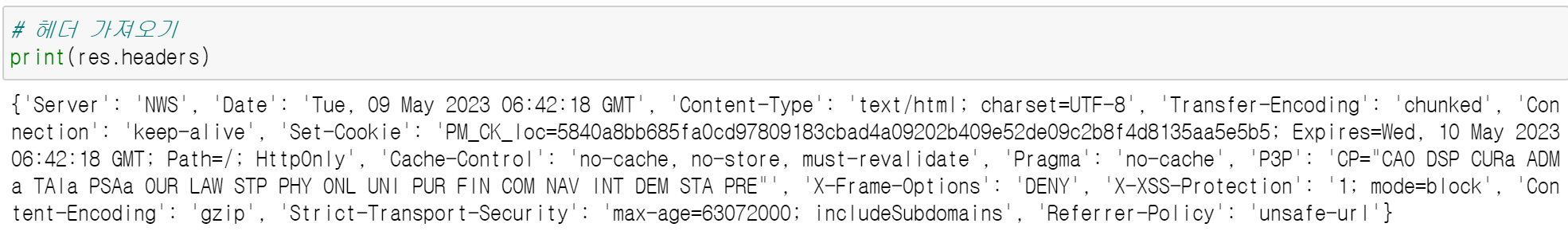

헤더란?

쿠팡아저씨가 새벽배송 오기 전에 보내주는 문자 같은 것. 택배는 body, 먼저 보내주는 문자는 header.

저장 되거나 전송되는 데이터 블록의 맨 앞에 위치한 데이터라고 한다.

태그

메타 태그

타이틀 태그

# 바이너리 형태로 값을 가져오기 때문에 res.text에서 한글이 깨지는 현상을 방지할 수 있음

print(res.content)

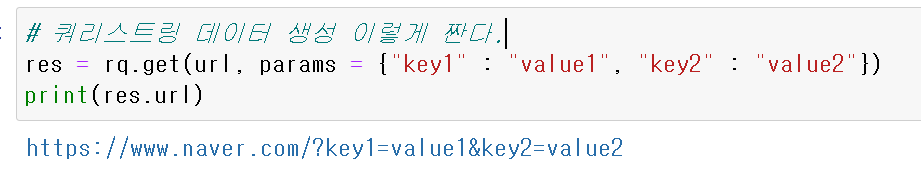

쿼리스트링 데이터 생성

res = rq.get(url, params = {"key1" : "value1", "key2" : "value2"})

print(res.url)params란?

params는 HTTP 요청을 보낼 때 쿼리스트링을 지정하는 파라미터

파이썬에서는 requests 모듈을 사용하여 HTTP 요청을 보낼 때, URL 뒤에 쿼리스트링을 추가하려면 params 파라미터를 사용

#urllib으로 웹페이지 접속

from urllib.request import urlopen

url = "https://www.naver.com"

page = urlopen(url)

print(page)

print(page.code)

print(headers)

print(page.url)

print(page.read())

# 정적 크롤링 모듈

from bs4 import BeautifulSoup

from urllib.request import urlopenBeautifulSoup은 요청 모듈로 가져온 HTML 코드를 파이썬이 쓸 수 있는 형태로 변환해주는 역할

BeautifulSoup은 HTML, XML 등의 마크업 언어로 작성된 문서를 파싱하고, 파싱한 결과를 파이썬에서 쉽게 다룰 수 있는 형태로 변환해주는 라이브러리(GPT출처)

url = "http://www.naver.com"

page = urlopen(url)

soup = BeautifulSoup(page, "lxml")"lxml" << 파서, 파싱이란 내가 원하는 데이터를 특정 패턴이나 순서로 추출하여 정보를 가공해주는 프로그램

-lxml , html5lib, html.parser 등이 있다.

lxml: C언어로 구현되어 속도가 가장 빠르다.

html5lib: 웹브라우저 형태로 HTML을 분석하여 속도가 가장 느리고 가장 안정적이다.

html.parser: lxml과 html5lib의 중간 속도이다.

속성 데이터

html = """<html> <head><title class="t" id="ti">test site</title></head> <body> <p>test</p> <p>test1</p> <p>test2</p> </body></html>"""<html> ~ </html> 까지 닫혀있다.

html 내부에서 <head> 자식 태그가 열리고 닫힌다.

-html(가장 상위)

-head

-title (class "t" id "ti")는 속성, id는 고유한 값, 동일한 id는 두 번 등장할 수 없다

-body 태그는 head 태그와 동등한 위치, head와 body 태그는 형제 태그

-p

-p

-p

soup = BeautifulSoup(html, "lxml")

soup<html> <head><title class="t" id="ti">test site</title></head> <body> <p>test</p> <p>test1</p> <p>test2</p> </body></html>

tag_title = soup.title

print(tag_title)

print(tag_title.attrs) # 태그의 속성 가져오기

print(tag_title["class"]) # 딕셔너리 처럼 접근할 수 있고 딕셔너리 문법을 그대로 적용할 수 있음,

키가 없다면 에러 발생

print(tag_title["id"])<title class="t" id="ti">test site</title>

{'class': ['t'], 'id': 'ti'}

['t']

ti

태그 접근

soup.태그이름 의 형태로 첫 번째로 등장하는 태그의 정보를 가져올 수 있음

원하는 정보를 추출해올 수 있다.

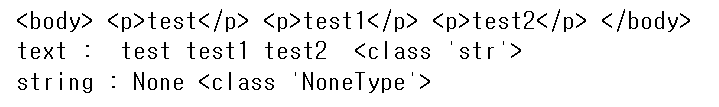

# text와 string의 차이

tag_body = soup.body

data_text = tag_body.text

data_string = tag_body.string

pring(tag_body)

print("text :", data_text, type(data_text)) #하위 태그들의 값도 모두 출력

print("string :", data_string, type(data_string)) # 정확히 해당 태그에 대한 값만 출력

text: 하위 태그들의 값도 모두 출력

string: 정확히 해당 태그에 대한 값만 출력

tag_body.p<p>test</p>tag_body.p.string'test'

# 원하는 요소에 접근하기 find_all()

-원하는 태그들을 리스트 형태로 가져오기

-html

-head

-title

-body

-p

-p

-p

-a

-b

html = """<html> <head><title>test site</title></head> <body> <p id="i" class="a">test1</p><p id="d" class="d">test2</p><p class="c">test3</p></p><a>a tag</a> <b>b tag</b></body></html>"""soup = BeautifulSoup(html, "lxml")soup.find_all("title")[<title>test site</title>]하나밖에 없다고 할지언정 리스트 형태로 모두 가지고 나온다.

soup.find_all("p")[<p class="a" id="i">test1</p>,

<p class="d" id="d">test2</p>,

<p class="c">test3</p>]soup.find_all("p")[1]<p class="d" id="d">test2</p>인덱스 슬라이싱 하기

soup.find_all(id = "d")[<p class="d" id="d">test2</p>]id의 존재 여부로 데이터 가져오기

# id의 존재 여부로 데이터 가져오기

soup.find_all(id = True)[<p class="a" id="i">test1</p>, <p class="d" id="d">test2</p>]원하는 태그, 원하는 id 값으로 태그 가져오기

# 원하는 태그, 원하는 id 값으로 태그 가져오기

print(soup.find_all("p", id = "d"))[<p class="d" id="d">test2</p>]없는 데이터 >> none

print(soup.find_all("p", id = "c"))[]soup.find_all("p", class_ = "c")[0].text'test3'

# find()

-하나의 요소만 가져옴

-찾고자 하는 요소가 하나만 있을 때 사용

예) id 값으로 접근

print(soup.find("p", class_ = "d"))

print(soup.find("p", id = "i"))

print(soup.find(id = "i"))<p class="d" id="d">test2</p>

<p class="a" id="i">test1</p>

<p class="a" id="i">test1</p>

바디 태그 안에서만 찾고 싶을 때?

연속으로 find 함수 사용

soup.find("body").find("p", class_ = "d")<p class="d" id="d">test2</p>

Select는 내일 이어서...!!!

'📂웹 개발(Web) > 🐍파이썬(Python)' 카테고리의 다른 글

| 파이썬 웹 크롤링 정적 크롤링 selenium 마우스 제어 키보드 제어 selenium과 bs4의 조합 (1) | 2023.05.10 |

|---|---|

| 파이썬 json (0) | 2023.02.08 |

| 파일복사/csv파일 읽기 쓰기 (0) | 2023.02.08 |

| 파일 만들고 읽기 (0) | 2023.02.06 |

| 지역변수(local) 전역변수(global) (0) | 2023.02.01 |